Google opublikowało przewodnik po zarządzaniu budżetem indeksowania. Zatem Crawl Budget zostało oficjalnie uwolnione i webmasterzy powinni jak najszybciej się tym tematem zainteresować. Koniec z domysłami…

Autorem ilustracji jest Seobility, Licencja: CC BY-SA 4.0

Zagadnienie Crawl Budget choć odnosi się bardziej do dużych szybko aktualizowanych domen których Google nie jest w stanie skanować za jednym zamachem to warto wiedzieć co piszczy w trawie i jak pomóc wyszukiwarce w sprawnym indeksowaniu swojej witryny. Co to znaczy, że jeśli Twoja strona zawiera ponad milion unikalnych stron z treścią aktualizowaną raz w tygodniu, albo ponad 10 000 stron z treścią aktualizowaną codziennie. Zatem dla typowego przedstawiciela branży foto to niemal nieistotne zagadnienie w kwestii SEO stron fotografa.

Spis treści

Czym jest crawl budget, crawl capacity i crawl demand?

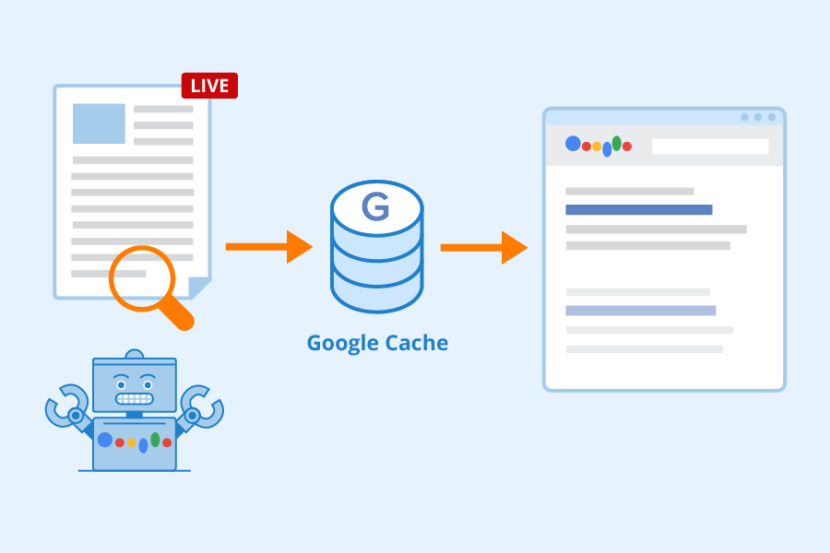

Zatem od początku. Aby strona znalazła się w wynikach wyszukiwania musi zostać zaindeksowana. Zadanie to wykonują boty – crawlery które regularnie przeszukują sieć w poszukiwaniu treści i mówiąc potocznie – czytają każdą napotkaną stronę opisując ją wieloma wskaźnikami – tak, aby wyszukiwarka mogła zrozumieć o czym ta strona jest i jak odnosi się do zapytania wpisanego przez internautę w Google.

Każda wyszukiwarka (bo Google nie jest jedyne) ma swoje crawlery które idą po stronie napotykają treści, zdjęcia, meta tagi czy linki do stron i czytają treści na nich zawarte. Podążają również za linkami tak jak robi to zwykły użytkownik (mniej więcej). Delegując do tego odpowiednie zasoby i okres czasu (bo nie da się zeskanować całego internetu w jednej chwili).

Crawl budget co to jest?

Crawl budget, a po polsku budżet indeksowania to w skrócie zasoby bota Google które są przeznaczane na skanowanie danej strony. Co ważne, ten budżet określa samo Google i nijak nie masz na niego wpływu – przynajmniej wprost. Wyobraź sobie, że masz za zadanie przeczytać 10 książek, w miarę jednocześnie – sam decydujesz ile czasu na którą i w jakiej kolejności poświęcić. Mniej więcej o tym tu mowa.

Crawl limit to limit wydajności indeksowania. Mówiąc obrazowo – gdyby Bot Google wpadł na Twoją stronę i poprosił o wyświetlenie wszystkich podstron, wpisów i zdjęć – zapcha serwer i spowoduje wywołanie błędu 500 – czyli wywali stronę na łopatki. Zatem ogranicza on ilość zapytań według swoich mocy przerobowych, ale i wydajności witryny. Inną liczbę zapytań wytrzyma Twoja strona, a inną portal wielkości Wirtualnej Polski. Zatem Google wewnątrz swoich mechanizmów decyduje o tym ile zapytań do jakiej witryny i kiedy wysłać.

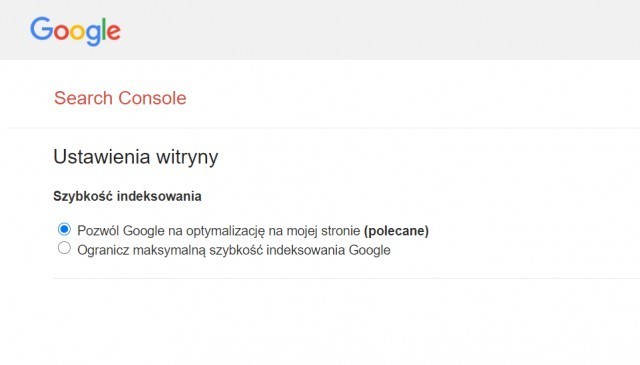

Jak widzisz, dochodzimy tu do kolejnego dowodu dla którego dobry hosting dla fotografa i każdego innego właściciela strony ma znaczenie. Może się okazać, że wpłynie on wprost na szybkość indeksowania – więc jeśli wiesz, że ten aspekt strony internetowej fotografa kuleje – może warto zainteresować się ręcznym ogranicznikiem prędkości indeksowania. Co nie jest pozbawione sensu – przyznaj się sam przed sobą – jak często wrzucasz nowe treści na stronę?

Crawl demand to z kolei mechanizm który ma odpowiedzieć na pytanie “jak często bot ma odwiedzać adres url”. Tu logika każe sama wnioskować, że miejsca gdzie dochodzi do rotacji tekstów będą skanowaneczęściej niż np. wpis na blogu sprzed 3 lat. Zatem tu na prowadzenie mogą się wysunąć fotografowie publikujący często, regularnie i wrzucający zajawki wpisów na stronie głównej. Wynika z tego też jeden wniosek – bardziej popularne domeny z większym zapleczem backlinków będą skanowane częściej niż domeny linków pozbawione.

Wskazówki optymalizacji crawl budget, oficjalne wytyczne Google:

- Blokuj indeksowanie nieistotnych stron, dużych elementów spowalniających ładowanie strony

- Stosuj tag kanoniczny (rel=canonical) dla zduplikowanych treści

- Usunięte strony powinny odpowiadać kodem serwera 404 lub 410

- Usuń pozorne błędy 404 (czyli sytuacje w których serwer wysyła kod odpowiedzi 200 odpowiedni dla prawidłowych stron, zamiast kodu 404 lub 410)

- Odświeżaj mapę witryny (Sitemap) z użyciem tagu lastmod

- Używaj prawidłowego kodu do budowy linków

- Nie stosuj długich łańcuchów przekierowań 301

- Przyspiesz wczytywanie strony

- Monitoruj stan indeksowania w sekcji statystyki indeksowania w Google Search Console

Czym crawl budget nie jest? Oto kilka mitów i faktów:

Nieprawdziwe jest, to że:

- Kompresja mapy witryny zwiększą limit indeksowania

- Częściej aktualizowane strony lub przeciwnie, stare treści są lepiej oceniane przez Google

- Parametry i generalnie skomplikowane adresy URL mogą stanowić problem

- Mniejsze strony są rzadziej „crawlowanie” bez względu na częstotliwość aktualizacji treści

- Kwestie indeksowania stanowią czynnik rankingowy

- Polecenie opóźnienia indeksowania (crawl delay) w robots.txt jest przetwarzane przez googlebota

Prawdą za to jest to, że:

- Strony bliżej strony głównej są częściej indeksowane

- Im szybciej wczytuje się strona, tym większy crawl limit

- Im więcej błędów serwera, tym mniejszy crawl limit

- Alternatywne adresy URL (np. z parametrem hreflang) są uwzględnione w crawl budget

- Użycie tag nofollow w linku sprawi, że boty indeksujące nie trafią do danej podstrony, aczkolwiek nie oznacza to, że nie dotrze do niej z innego linku niezawierającego dyrektywy nofollow

Więcej o tym znajdziesz niebawem i tu, i na Merytorycznie o Biznesie Fotografa